Es probable que en 2060 dispongamos de dispositivos móviles con acceso a la supercomputación. Para ello, tendremos que abordar – en las próximas décadas- el problema de los sistemas distribuidos de computación. Este avance se deberá al progreso en:

- La computación y las infraestructuras cloud.

- Los algoritmos de aprendizaje automático y la disponibilidad de grandes cantidades de datos, de diversos tipos y formatos.

- El avance de las telecomunicaciones -un factor clave a corto plazo- con el despliegue de redes de muy baja latencia (5G) y el desacoplamiento de las infraestructuras físicas para crear redes lógicas que puedan funcionar en paralelo (‘network slicing’).

Por ejemplo, un sistema de movilidad basado en vehículos autónomos necesitaría una computación distribuida de muy altas prestaciones, una gran cantidad de sensores dentro y fuera de los vehículos, y redes de muy baja latencia que, además, permitieran en paralelo transmitir información sobre sistemas de movilidad, entretenimiento y aplicaciones empresariales, por ejemplo.

La digitalización, que actualmente afecta al 46% de los negocios, es lo que explica el incremento en el gasto en infraestructuras cloud, que creció un 32% el año 2020 hasta alcanzar los 40.000 millones de dólares. En mi opinión, la escalabilidad en materia de computación con la tecnología actual podría estar entrando en una fase de saturación no solo por sus costes, sino por su arquitectura, que sigue siendo la misma que propuso Touring y Von Neumann en los años 40 del siglo pasado y por problemas de sostenibilidad energética.

Índice de temas

Energía y sostenibilidad

Los procesos de cálculo soportados por los sistemas de computación actuales no escalan lo suficiente en relación con sus demandas energéticas, porque los sistemas de inteligencia artificial requieren feedback, eso es, ciclos de tiempo hacia adelante y ciclos de tiempo hacia atrás o computación con tiempo invertido (los algoritmos Back-Propagation Through Time – BPTT). Estos procesos requieren de mucha energía.

Los algoritmos de aprendizaje automático (machine learning) necesitan muchos datos y mucha potencia en computación. Ello requiere infraestructuras que requieren energía. Un gran centro de datos podría llegar a consumir 100 MW de potencia. Ello explica por qué Google, Microsoft y Amazon invierten, de forma prioritaria, en fuentes de energía sostenible. De hecho, el 56% de la energía que utiliza Google procede de fuentes renovables y, en el caso de Microsoft, el 32%.

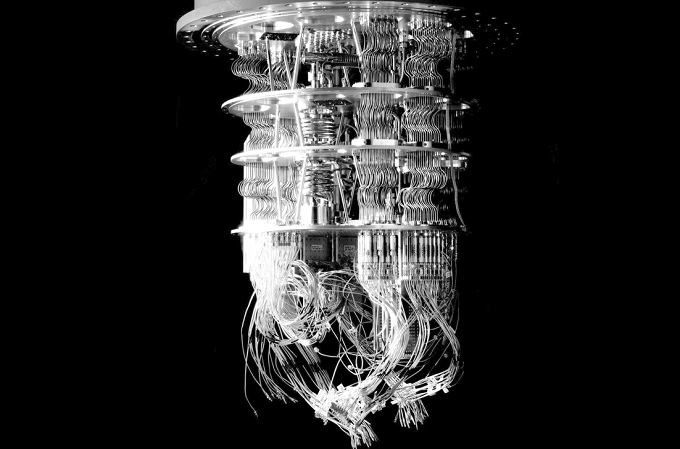

La computación cuántica permite lanzar procesos de cálculo en paralelo trabajando con más estados posibles en el sistema

Nuestro cerebro consume unos 20 W. Si nos ponemos la mano en la cabeza, aunque pensemos mucho, veremos que no sube la temperatura de forma apreciable. En contraste, un gran centro de procesamiento de datos tiene una capacidad de computación comparable al 20% de nuestro cerebro, ¡pero necesita 100 MW!! Es decir, si construyéramos un centro de procesamiento de datos equiparable a la capacidad de computación de nuestro cerebro, basado en 100.000 millones (1011) de neuronas, con una capacidad de mil billones (1015) de sinapsis, con la tecnología actual necesitaríamos cerca del 50% de la energía generada por una central nuclear, cuando nuestro cerebro consume lo mismo que una bombilla de poca intensidad.

Acaso la respuesta esté en la computación cuántica, que utiliza unas propiedades tales de la materia que permite codificar la información no en dos estados (1, 0), sino en cuatro (00, 01, 10, 11), lo cual permite un procesado de la información mucho más eficiente. La computación cuántica no es la computación que conocemos hoy, pero más rápida. Por decirlo de forma sencilla, la computación cuántica permite lanzar procesos de cálculo en paralelo trabajando con más estados posibles en el sistema precisamente por su forma de codificar la información.

El concepto de sistemas de supercomputación no dependerá únicamente de ordenadores, sino de modelos de datos y redes de muy alta velocidad

Estos nuevos sistemas de supercomputación tendrán que ir acompañados por nuevos algoritmos de inteligencia artificial (los actuales datan de los años cincuenta del siglo pasado). El Algoritmo Grover realiza búsquedas en bases de datos superponiendo varios procesos de cálculo en paralelo y haciendo un ranking de respuestas, haciendo aparecer la correcta en la primera posición. El algoritmo Grover solo necesita revisar 1.000 registros de una base de datos de 1.000.000 de posiciones. Los algoritmos actuales precisan 500.000 búsquedas. De ahí la supremacía cuántica en este tipo de problemas.

Modelos de datos

Volviendo al ejemplo de sistemas de movilidad urbana. En 2018, Microsoft y Ford realizaron un experimento en Seattle para abordar este problema. Con computación cuántica y los algoritmos adecuados consiguieron -para un conjunto de 5.000 vehículos- reducciones del 70% en atascos y congestiones y un ahorro próximo al 10% en los tiempos de desplazamiento, lo que supuso ahorros de unas 55.000 horas de tiempo. Por ello, también tendremos que avanzar desde los modelos de datos actuales hacia modelos de datos con más dimensiones para registrar y codificar más estados, e incorporar el tiempo de forma nativa. Esta es la razón por la cual Google Cirq e IBM Qiskit impulsan marcos de referencia para el desarrollo de algoritmos en la era cuántica. Es importante recalcar en el concepto de sistemas de supercomputación, que no dependerá únicamente de los ordenadores, sino de los modelos de datos y las redes de muy alta velocidad como he argumentado.

Con relación a los ordenadores cuánticos, existen problemas muy relevantes para hacerlos accesibles de forma comercial a corto plazo: transmiten información en un rango de frecuencias que dificulta mucho la creación de componentes. Trabajan con dispositivos de microondas, válvulas de vacío y puertas lógicas mecánicas, y en condiciones de muy bajas temperaturas. De ahí su forma actual, sus dimensiones y su demanda energética.

En las condiciones actuales, pensar en un ‘smartphone Q’ como sugería al principio del artículo es imposible. De hecho, pensar que ello sea posible -con los materiales y con las tecnologías actuales- desafía a las leyes físicas que conocemos. Pero también Lord Kelvin dijo a principios del siglo XX que era imposible que una máquina más pesada que el aire pudiera volar. Todavía no se había inventado la aerodinámica, la aviónica ni la propulsión para alcanzar la velocidad de escape. Esta fue la gran contribución de los hermanos Wright, que abrieron estos campos de conocimiento tras su primer vuelo con el Kitty Hawk.

Por tanto -y eso lo sabemos muy bien en tecnología-, que hoy no sepamos resolver un problema no significa que, en el futuro, algún niño que ahora esté estudiando en el colegio no esté llamado a liderar el salto hacia los sistemas de supercomputación del futuro. Creemos que ello puede ser posible entre 2050 y 2060. Es solo una suposición. ¡Habrá que cuidarse para verlo!

Artículo del Anuario 2022 de Computing