El panorama de la ciberseguridad se encuentra en un punto de inflexión marcado por una fragmentación sin precedentes de las amenazas y la adopción acelerada de la inteligencia artificial por parte de los atacantes. Actualmente, existe un récord de 85 grupos de ransomware activos, que realizan un promedio de 535 ataques al mes. Esta fragmentación, generada tras el éxito de las fuerzas del orden al frenar a grandes grupos de ciberdelincuentes el año pasado, ha resultado en la creación de múltiples bandas más pequeñas que compiten por el «mercado de la inseguridad». Lo más alarmante del uso de la IA es que está reduciendo la barrera tecnológica para los cibercriminales, permitiendo ataques de mayor complejidad con menos conocimientos.

A estas conclusiones ha llegado la firma de ciberseguridad Check Point, que ha reunido a los periodistas para hablar de la importancia de la «IA discriminativa» a la hora de detectar los comportamientos maliciosos, y del avance y la sofisticación de los ataques impulsados por la inteligencia artificial y que se cuelan por las brechas generadas por esta tecnología. «Los proveedores de ciberseguridad llevamos utilizando la IA más tiempo que los atacantes», dijo Mario García, Mario García, director general de Check Point Software para España y Portugal, «pero las empresas tienen que confiar en nosotros para estar mejor protegidas».

Índice de temas

La inteligencia artificial como arma de ataque y extorsión

La IA ha pasado de ser una fuerza de defensa a un motor clave en la ofensiva cibernética. Se ha detectado la presencia de grupos que utilizan inteligencia artificial para generar malware. «Los atacantes, por ejemplo, emplean la IA para generar código que luego se compila en lenguajes potentes como Rust, permitiendo a personas con menos conocimientos técnicos actuar como ‘coders’, -o personas que escriben código-, en lugar de programadores», explicó Eusebio Nieva, director técnico de Check Point para Iberia.

Un hito reciente, atribuido a un grupo chino, ha sido la perpetración del primer ataque prácticamente automatizado en su totalidad con IA, que fue detectado y prevenido por parte de la compañía de seguridad e investigación especializada en IA, Anthropic. «Este ataque utilizaba la inteligencia artificial para automatizar cerca del 80% de las acciones en las fases de reconocimiento, scanning, explotación de vulnerabilidades y movimientos laterales dentro de la red».

Lo más alarmante del uso de la IA es que está reduciendo la barrera tecnológica para los cibercriminales, permitiendo ataques de mayor complejidad con menos conocimientos

Además de generar código, la IA se utiliza para maximizar la extorsión. En los ataques de ransomware sin cifrado, -donde solo se roban datos para amenazar con borrarlos-, la inteligencia artificial analiza los datos para determinar cuáles son los más sensibles, -como la facturación de una empresa-; para incrementar la extorsión. Los ‘infostealers’, o ladrones de información, como el malware Rhadamanthys; juegan un papel crucial en este proceso. A nivel global, los sectores más golpeados son Servicios, Salud y Manufactura.

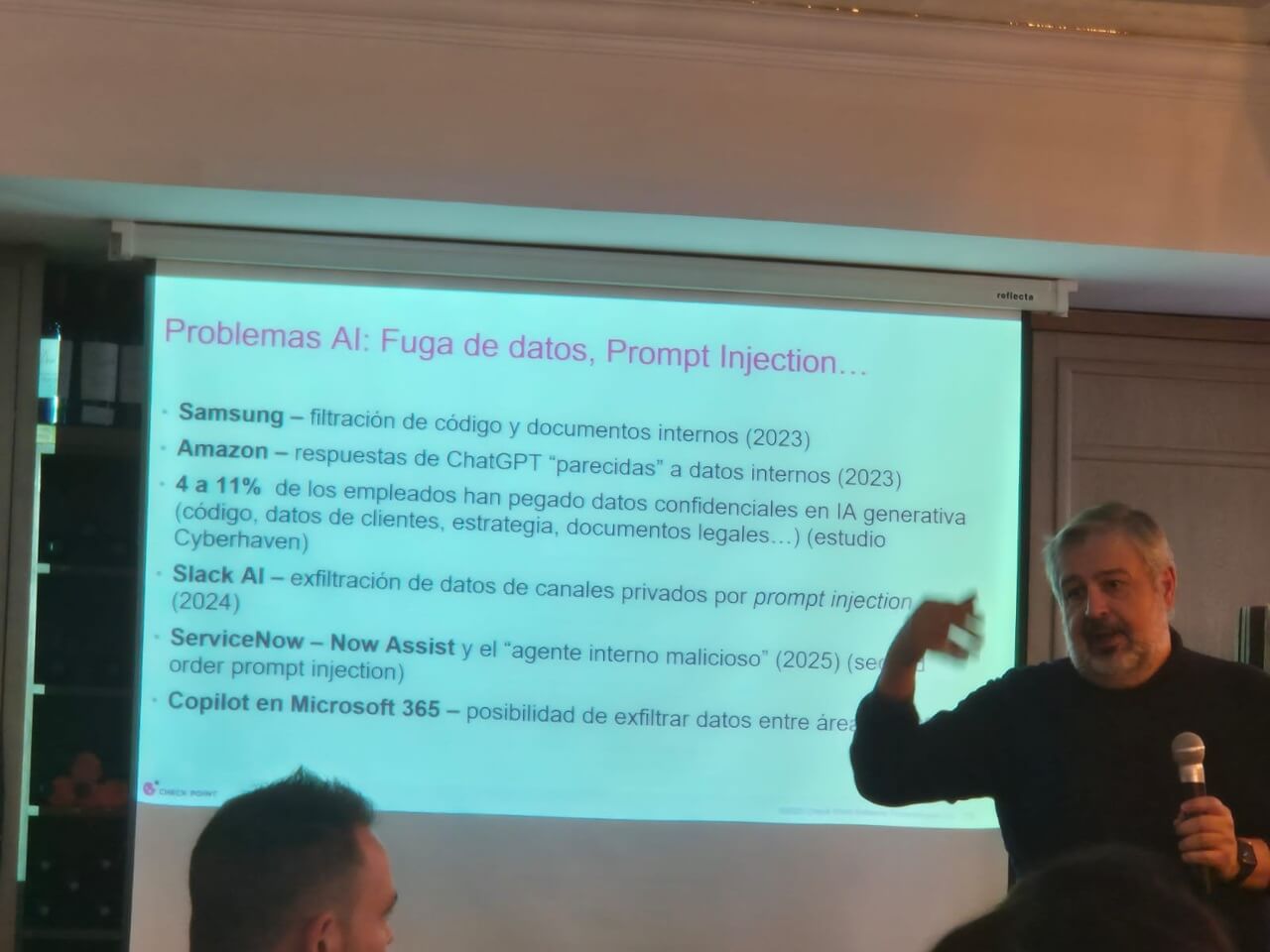

Ataques a la propia IA y fugas de datos

La IA no solo impulsa los ataques, sino que se ha convertido en un objetivo de éstos. Los ataques a la propia IA se centran en la fuga de datos y la manipulación del modelo. En este sentido podemos hablar de fuga de datos por prompt injection: Los empleados están utilizando herramientas de IA generativa (Shadow AI) para realizar tareas como arreglar código o transcribir reuniones, lo que resulta en la filtración involuntaria de código y documentación interna a las bases de aprendizaje de la IA. La técnica de prompt injection (inyección de comandos) se utiliza para saltarse las barreras de protección de la IA y extraer información confidencial de las bases de datos internas de las empresas.

Otro tipo de ataque perpetrado a las herramientas de IA es el model poisoning, o envenenamiento del modelo con información falsa. Antes se creía que se necesitaba mucho entrenamiento para engañar a una IA, pero estudios de Antrhopic sugieren que solo 250 documentos son suficientes para hacer que el modelo diga cosas sin sentido o que alucine. Por su lado, el model inversion consiste en robar los secretos del modelo de IA, que son la esencia del valor de las grandes compañías tecnológicas.

La IA como herramienta defensiva

Frente a la sofisticación de los ataques, la defensa también se apoya firmemente en la inteligencia artificial. Se utiliza la IA Discriminativa, el machine learning y el deep learning para diagnosticar y diferenciar entre lo bueno y lo malo. La IA es fundamental en el arsenal defensivo. «Se utilizan engines de IA para la detección de phishing de día cero, buscando identificar las amenazas antes de que sean conocidas y puedan hacer daño en las primeras 8 ó 10 horas después del ataque», contó Eusebio Nieva.

Otro uso de la IA en este caso es la detección de anomalías (XDR/MDR): La IA aprende el comportamiento normal de la organización (baseline) para detectar anomalías o alarmas que se salen de lo habitual, alertando de un posible ataque. También encontramos la mejora de precisión: El paso del machine learning tradicional al deep learning ha mejorado la precisión y prevención, reduciendo los falsos positivos de ataque en un 20% o 30%.

Por otra lado, la IA está disminuyendo las barreras técnicas también para los defensores. La última novedad en ciberseguridad es el ‘firewall autónomo‘, una herramienta que se instala, aprende y pone las reglas de seguridad automáticamente.

«La IA es una fuerza motriz tanto en la defensa como en el ataque», resumió Nieva, y terminó con un juego de palabras: «La IA es una aliada muy importante para la ciberseguridad, pero también representa ‘una liada’ muy importante».